Grundlagen zur Verzerrung bei Mikrofonen

Wir möchten unerwünschte Verzerrungen in unserer Aufnahmekette vermeiden. Doch leider treten diese in der Regel immer auf, selbst wenn sie unterhalb der Hörschwelle liegen. Beim Aufbau der Aufnahmekette können die einzelnen Komponenten zur Gesamtverzerrung beitragen, die schließlich hörbar werden kann.

Bevor wir uns mit dem Ausmaß der Verzerrung befassen, müssen wir die verschiedenen Formen der Verzerrung definieren, denen wir in unseren Geräten begegnen – in diesem Fall mit besonderem Schwerpunkt auf Mikrofonen. Außerdem müssen wir das Hörsystem (Ohren und Gehirn) berücksichtigen, das die tatsächlichen Grenzen der Hörbarkeit setzt.

Verzerrung – linear oder nichtlinear?

Wenn ein Signal vom Eingang zum Ausgang gelangt, kann jede Veränderung dieses Signals (d. h. der Signalwellenform) als Verzerrung betrachtet werden. Im Großen und Ganzen sind alle Verzerrungen nichtlinear. Die Veränderung der Amplitude kann jedoch als „lineare Verzerrung” betrachtet werden, da sie zu einem späteren Zeitpunkt korrigiert werden kann. Die Verzögerung eines Signals wird manchmal ebenfalls als lineare Verzerrung betrachtet, da die Wellenform intakt ist und lediglich etwas später übertragen wird.

Aufgrund dieser Definitionen verursacht jede absichtlich vorgenommene Entzerrung, jede Änderung der Bandbreite und jede Begrenzung eine Art Verzerrung. Wir sollten uns jedoch der unbeabsichtigten Verzerrung und ihrer Auswirkungen auf die wahrgenommene Klangqualität bewusst sein.

Verzerrung - woher kommt sie?

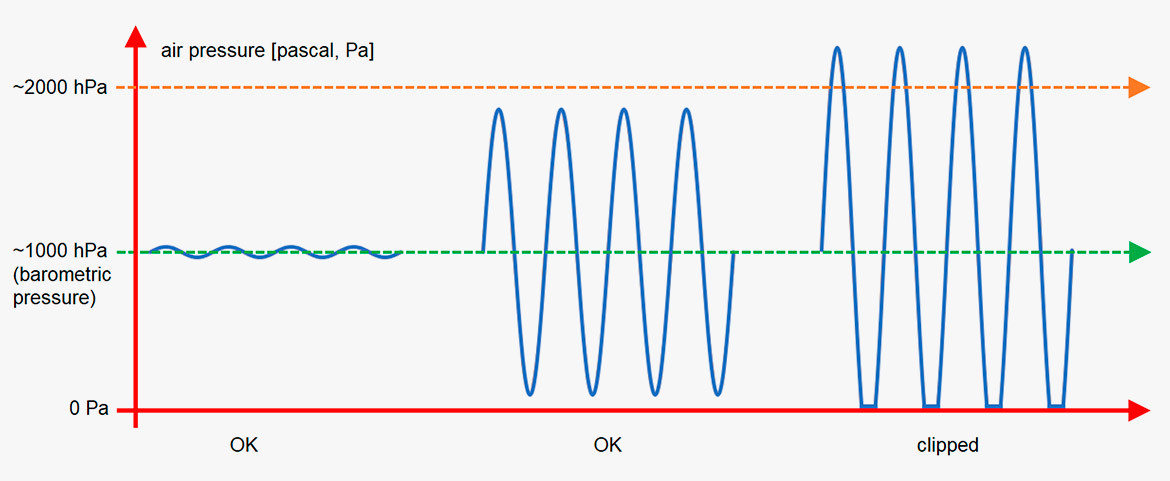

Verzerrungen entstehen durch Begrenzungen und andere Nichtlinearitäten in einem System. Selbst der Schall in der Luft hat eine begrenzte Amplitude. Wenn der Schalldruckpegel 194 dB SPL überschreitet, gibt es keine Luftmoleküle mehr, die den negativen Teil der Schallwelle bilden können, da ein vollständiges Vakuum erreicht ist. (Siehe Abbildung unten).

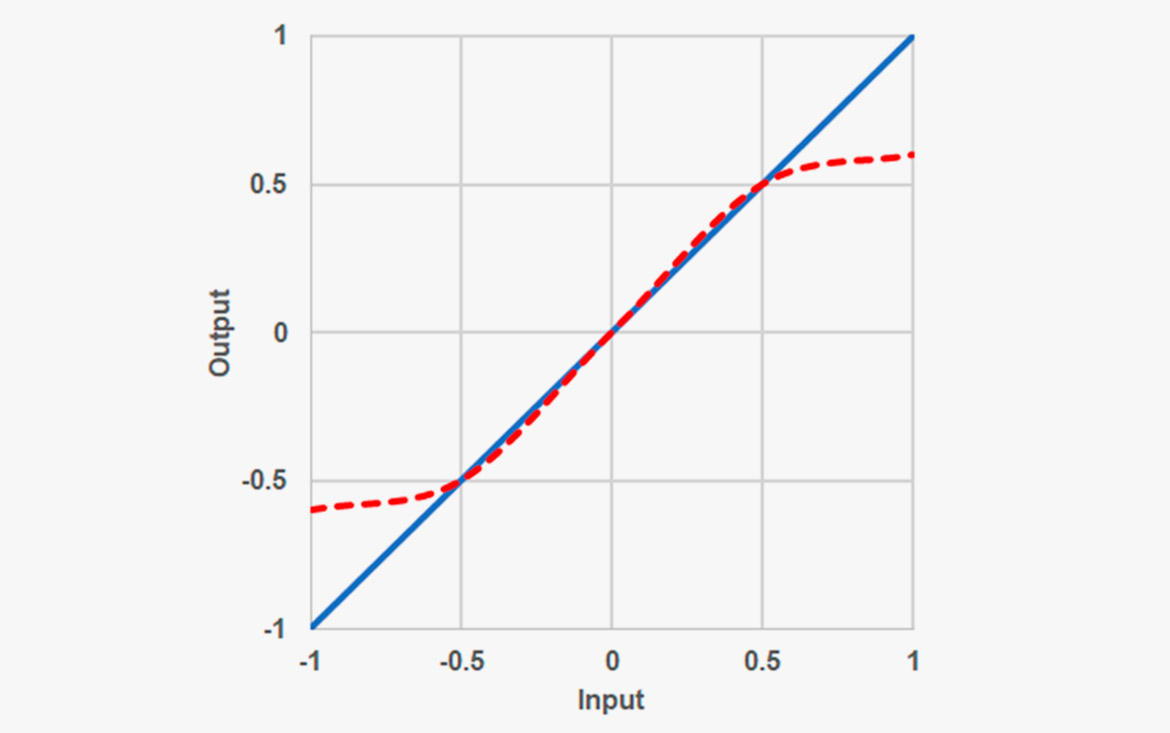

Abbildung 1: Verzerrung in der Luft bei einem Schalldruckpegel über 194 dB.

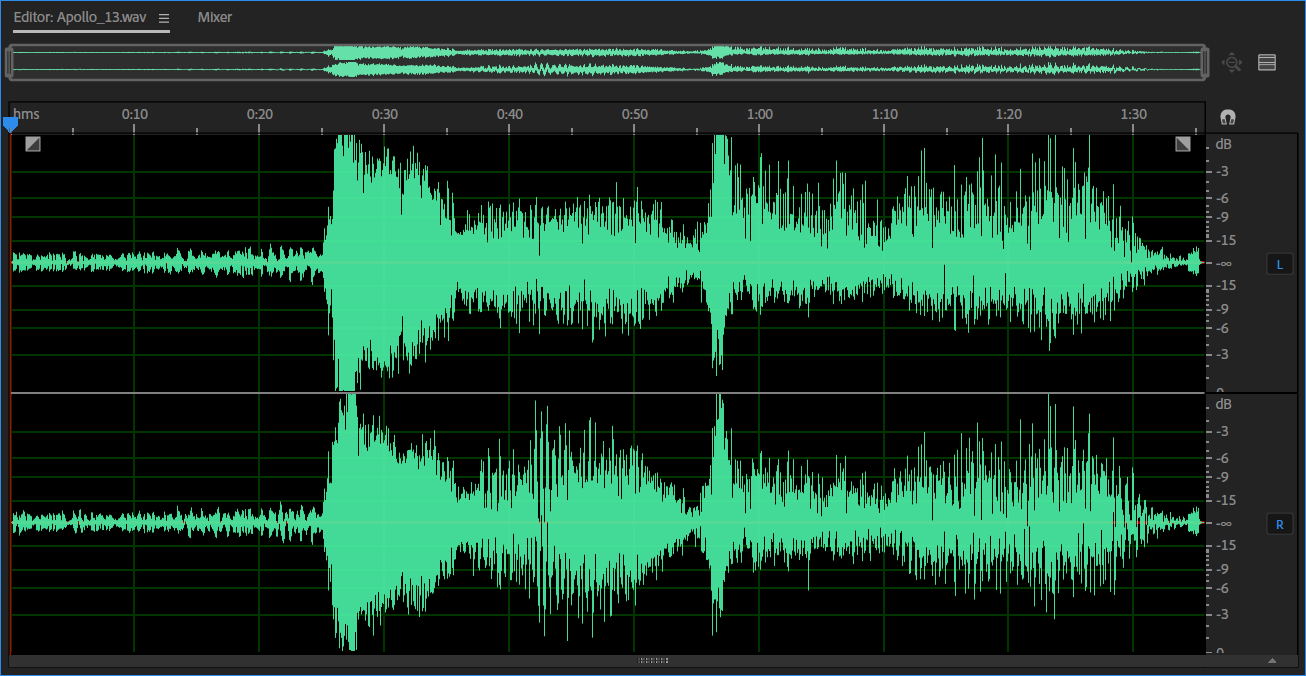

Abbildung 2. Audiodatei: Start der Apollo 13. Nach 60 Sekunden hört man etwas, das wie starke Verzerrung klingt. Das ist die Verzerrung in der Luft. Wenn man sich die Wellenform (oben) ansieht, erkennt man, dass die positiven Bereiche höher sind als die negativen.

Verzerrung in Mikrofonen

Ein wichtiger Teil des Mikrofons ist die Membran. Bei einem Kondensatormikrofon sitzt die Membran vor einer Rückplatte. Der Abstand zwischen den beiden ist etwa 20 bis 50 µm.

Wenn das Mikrofon in einer Umgebung mit hohem Schalldruckpegel eingesetzt wird, ist klar, dass die Auslenkung der Membran begrenzt ist, zumindest wenn sie in Richtung der Rückplatte bewegt wird. Außerdem ist das Material der Membran selbst nur begrenzt in beide Richtungen dehnbar.

Jedes Kondensatormikrofon braucht eine elektronische Zwischenstufe, die die hohe Impedanz des Wandlers in eine relativ niedrige Impedanz umwandelt, um längere Kabelwege zu versorgen. Diese Elektronik kann eine Ursache für unsymmetrisches Verhalten sein. (CORE by DPA ist ein erfolgreicher Versuch, dies zu verbessern. CORE+ by DPA ist eine Technologie zum Ausgleich von Membranbeschränkungen, im Grunde bis zum Punkt des Clippings).

Obwohl die Hersteller ständig versuchen, die Mikrofone zu verbessern, gibt es Grenzen der Mikrofonsysteme, die letztendlich zu Verzerrungen führen können.

Abbildung 3. Eine Möglichkeit, die Nichtlinearitäten eines Systems zu beschreiben. Die blaue Kurve: Keine Begrenzungen. Die rote gestrichelte Kurve: Begrenzungen im System.

Wie wird Verzerrung angegeben?

Nach den IEC-Normen [1, 2] wird die Amplitudenverzerrung durch drei Messgrößen ausgedrückt: die Gesamtverzerrung (THD), die Verzerrung n-ter Ordnung und die Differenzfrequenzverzerrung zweiter Ordnung. Was bedeuten diese Begriffe?

Gesamtverzerrung: Eine reine Sinuswelle besteht aus genau einer Frequenz. Bei Verzerrung (typischerweise durch Clipping) entstehen zusätzliche Frequenzen – ganzzahlige Vielfache des Grundtons. Wenn das Mikrofon in einem Schallfeld mit einem reinen Ton (z. B. 1 kHz) platziert wird, enthalten die Verzerrungsprodukte – die erzeugten Obertöne – Frequenzanteile bei 2 kHz, 3 kHz, 4 kHz usw., deren Pegel normalerweise abnimmt. (Bei symmetrischem Clipping werden nur ungerade Obertöne erzeugt, also der 3., 5., 7. usw.).

Die THD-Messung wird durchgeführt, indem der Betrag (RMS) aller höheren Obertöne als Prozentsatz des Pegels der Grundfrequenz gemessen wird. Das Ergebnis sollte im besten Fall im größten Teil des Dynamikbereichs unter 1 % liegen. 1 % harmonische Verzerrung bedeutet, dass die unerwünschten Frequenzanteile einen Pegel haben, der 40 dB unter der Grundfrequenz liegt. Das ist ein Grenzwert, den viele Mikrofonhersteller bevorzugen. Das ist auch ein „optischer” Grenzwert, da diese Verzerrung auf der Wellenform sichtbar wird, zum Beispiel auf einem Oszilloskop oder wenn sie aufgenommen und in der DAW angesehen wird.

Abbildung 4. THD ist der Anteil der Oberschwingungen, die durch Nichtlinearität, zum Beispiel Clipping, entstehen.

In der Praxis ist es schwierig, den THD bei niedrigen bis mittleren Schalldruckpegeln zu messen, da der Lautsprecher normalerweise eine höhere Verzerrung aufweist als das Mikrofon. Wenn man sich jedoch den maximalen Schalldruckpegeln des Mikrofons nähert, kann der THD schnell ansteigen.

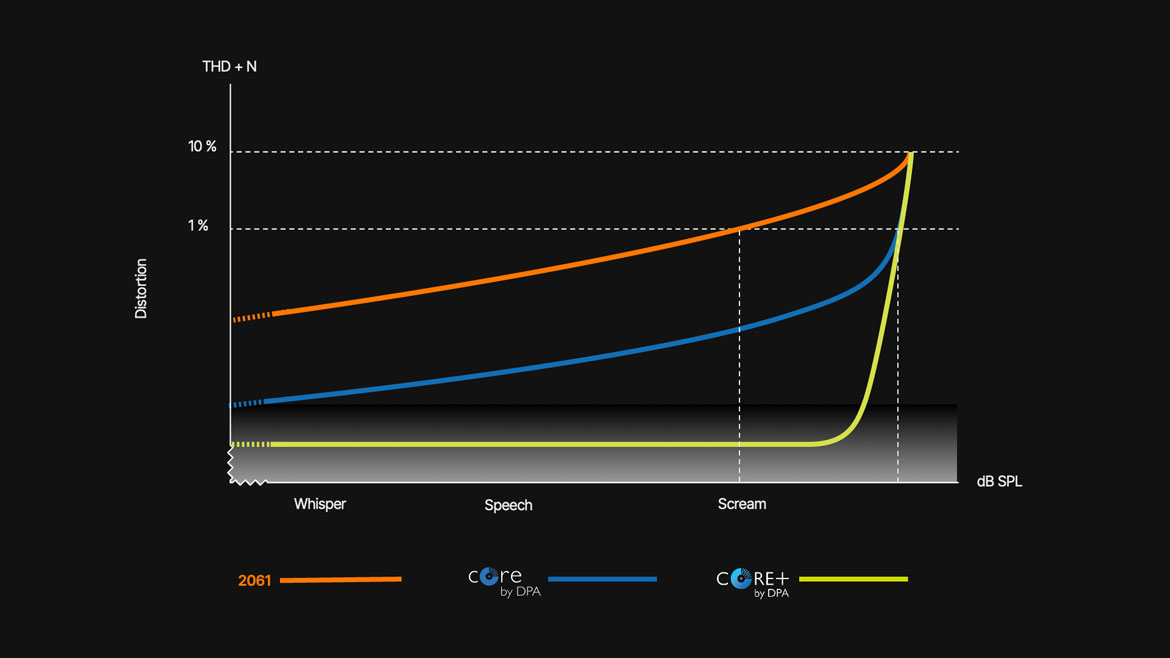

Abbildung 5. Die Auswirkungen von CORE und CORE+ durch DPA in Miniaturmikrofonen: Die Kurven zeigen die Verzerrung als Funktion des Schalldruckpegels (SPL).

Die obere orangefarbene Kurve zeigt die Verzerrung der alten Mikrofone ohne jegliche Kompensation.

Die blaue Kurve zeigt die Verbesserung der Elektronik, die den Dynamikbereich des Mikrofons (um 14 dB) erhöht. Der Clipping-Punkt (10 % THD) ist jedoch derselbe wie zuvor.

Die untere grüne Kurve zeigt die Verzerrung nach der Einführung von CORE+. Jetzt ist der THD auf allen Pegeln bis zur endgültigen Begrenzung extrem niedrig.

Verzerrung n-ter Ordnung: Diese entspricht im Prinzip dem THD, außer dass die Oberwellen einzeln gemessen und quantifiziert werden. Manchmal ist die dritte Oberwelle von besonderem Interesse, da sie durch symmetrisches Clipping die Oberwelle ist, die den höchsten Pegel aller erzeugten Oberwellen darstellt.

Differenzfrequenzverzerrung: Für diese Messung werden zwei reine Sinustöne mit identischen Pegeln angelegt. Die IEC-Norm definiert den Abstand zwischen den Frequenzen mit 80 Hz. Ein Beispiel für Frequenzen sind 1000 Hz und 1080 Hz. Es kann jedoch auch ein Sweep über einen größeren Bereich angewendet werden. Eine Differenzverzerrung erzeugt Summen- und Differenzfrequenzen (d. h. 1000 Hz und 1100 Hz erzeugen eine Differenzfrequenz von 100 Hz). Diese Frequenzkomponenten werden gemessen und als Prozentsatz der Grundfrequenzen quantifiziert.

Es ist zu beachten, dass es völlig in Ordnung ist, eine standardisierte Methode zur Quantifizierung von Verzerrungen anzuwenden. Die Normen berücksichtigen jedoch nur eine kleine Auswahl möglicher Verzerrungsformen. In der Realität sind Signale weitaus komplexer, ebenso wie die Verzerrungskomponenten.

Was ist hörbar?

Um herauszufinden, was entscheidend ist, müssen wir uns mit der psychoakustischen Forschung beschäftigen. Hier sind einige Phänomene, die die wahrgenommene Klangqualität beeinflussen.

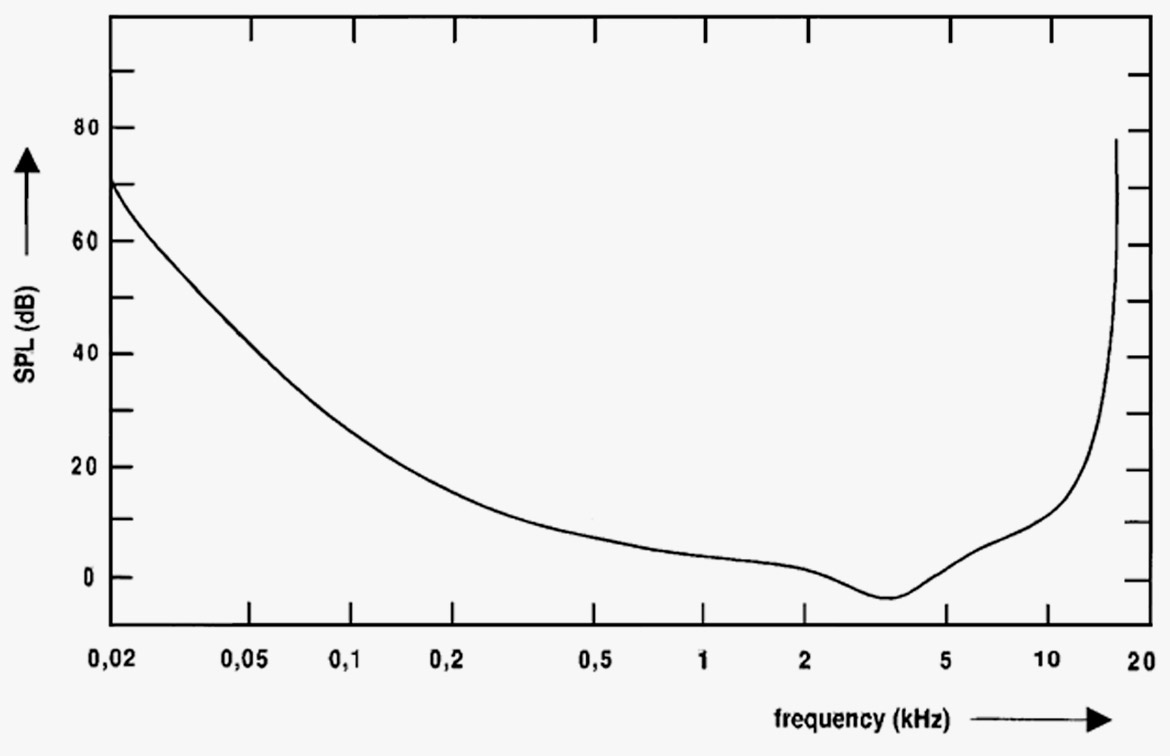

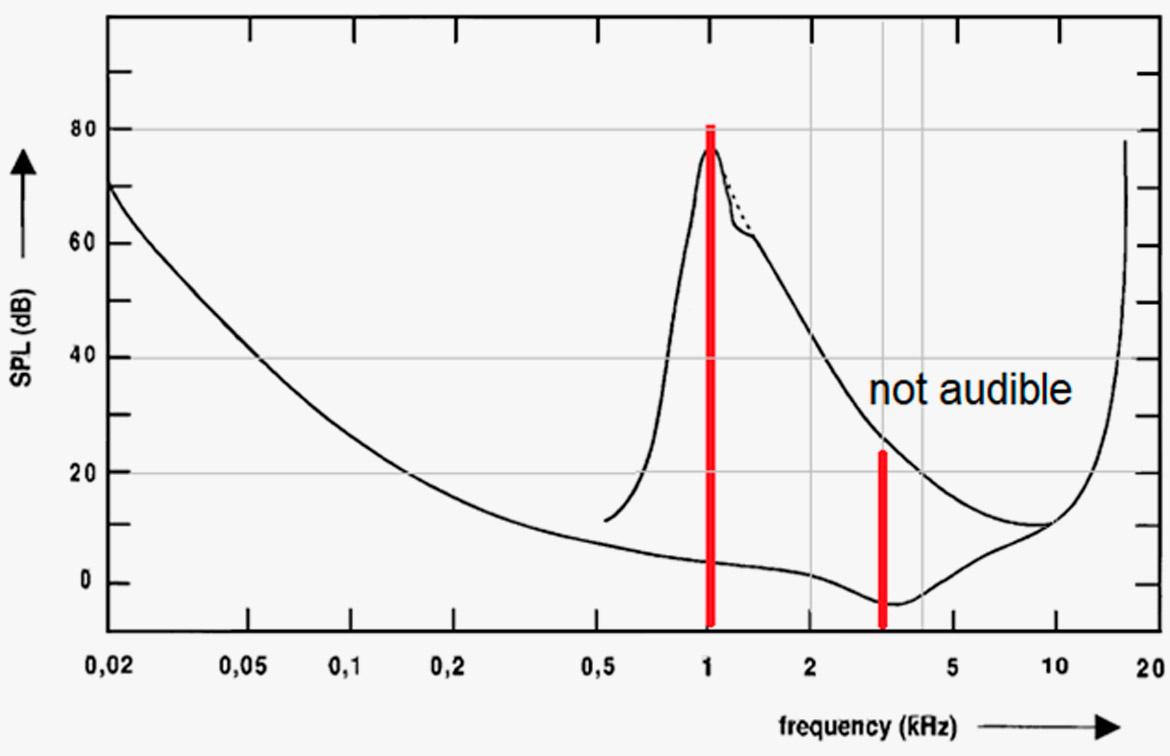

Hörschwelle: Unser Gehör hat eine natürliche Untergrenze. Diese Grenze variiert je nach Frequenz. Bei niedrigen Frequenzen ist die Hörschwelle ziemlich hoch. Im Frequenzbereich von 2–4 kHz ist die Hörschwelle niedrig. Siehe Abbildung 5.

Abbildung 6. Die Kurve zeigt die Hörschwelle (für Leute mit normalem Gehör). Menschen können Töne unterhalb dieser Schwelle nicht hören. Beachte, dass Menschen tiefe Frequenzen nicht so gut hören.

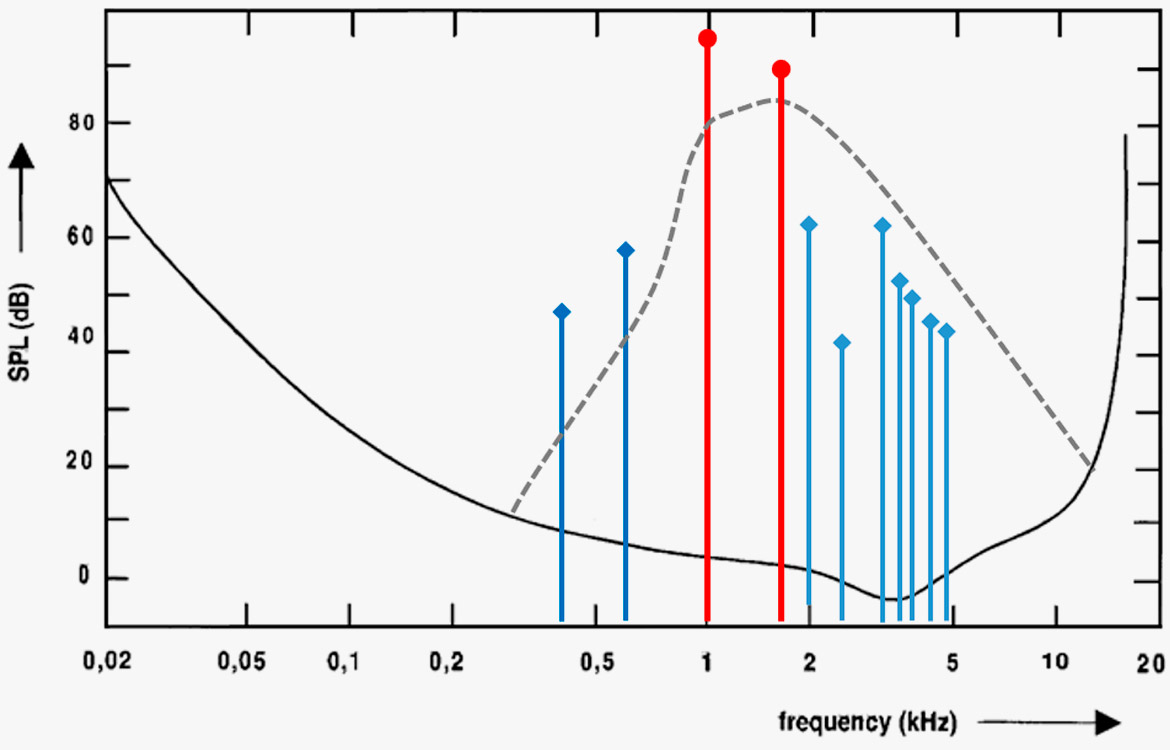

Maskierung: Wenn das Ohr Schallenergie in einem bestimmten Frequenzbereich ausgesetzt ist, werden die umliegenden Frequenzen maskiert. Das passiert vor allem bei höheren Frequenzen.

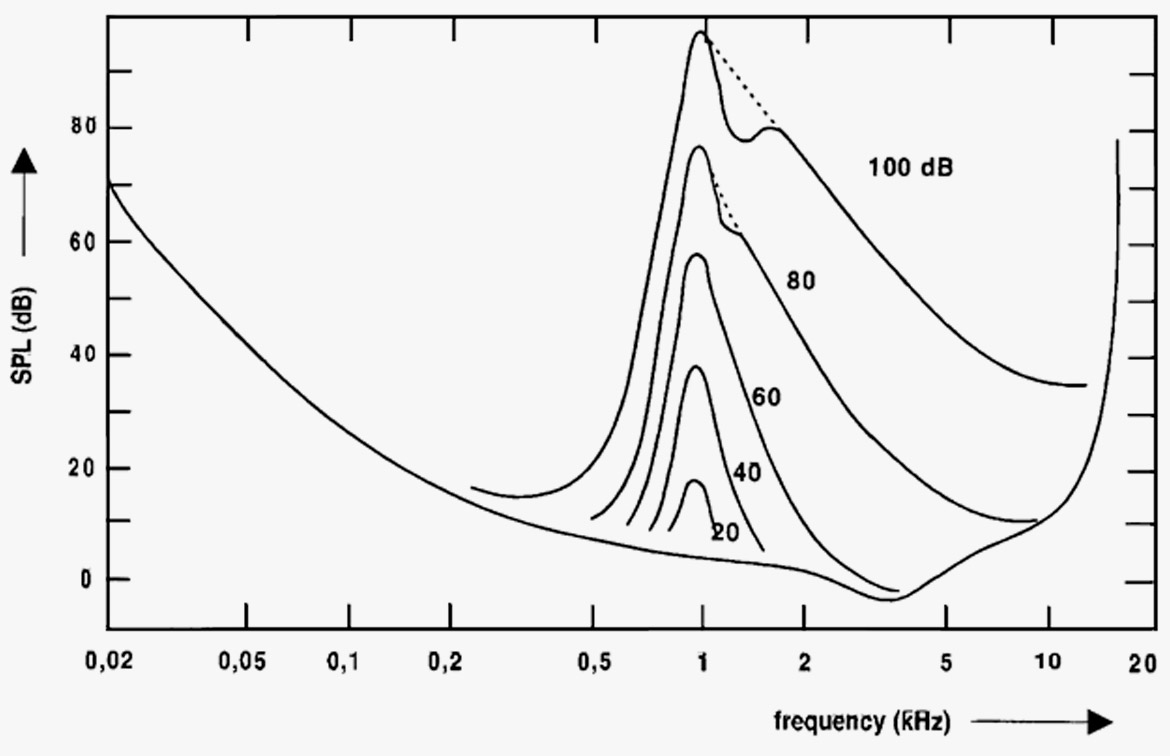

Die Abbildung unten zeigt die Maskierungskurven eines 1-kHz-Reintons bei verschiedenen Schalldruckpegeln (SPL).

Abbildung 7. Das Diagramm zeigt die Maskierungskurven eines reinen 1-kHz-Tons bei verschiedenen Schalldruckpegeln.

Das heißt, dass die Verzerrungskomponenten oft nicht mehr zu hören sind, weil sie überlagert werden.

Abbildung 8. Die dritte Harmonische (3 kHz) des 1-kHz-Tons ist wegen der Maskierung nicht zu hören, obwohl die Verzerrung 5 % beträgt.

Bei der Differenzfrequenzverzerrung sind die Frequenzanteile unterhalb der Maskierungsfrequenzen am besten zu hören. Das hängt auch damit zusammen, dass die Differenztöne nicht unbedingt musikalisch sind und daher als störender empfunden werden.

Der Maskierungseffekt ist bei allen bitreduzierten Audioformaten wichtig. Hier kann die Verzerrung hoch und das Signal-Rausch-Verhältnis niedrig sein. Aber wir (also die meisten Leute, die zuhören) finden das oft okay.

Verzerrung des Ohrs: Das Ohr selbst erzeugt Verzerrungen. Dieses Phänomen tritt vor allem bei höheren Schalldruckpegeln auf. Das Ohr hat seine beste Auflösung bei niedrigeren Schalldruckpegeln.

Dieses Phänomen nimmt man wahr, wenn man zwei Töne hört, die fast gleich laut sind. Je nach Frequenzintervall zwischen den beiden Tönen kann ein dritter Ton gehört werden. Wenn man beispielsweise zwei Töne mit einem Intervall von einer Quinte hört, C3 und G3 (131 Hz und 196 Hz), erzeugt das Ohr den Differenzton von 65 Hz (C2, eine Oktave unter C3. Diese Tatsache wird beim Bau von Pfeifenorgeln genutzt, um „künstliche Unterstimmen” zu erzeugen).

Unten siehst Du ein Beispiel für Intermodulation oder Differenzfrequenzverzerrung. Es werden zwei Töne erzeugt. Das Ohr erzeugt dann eine Differenztonverzerrung. Allerdings werden aufgrund der Maskierung nur die Töne unterhalb des eigentlichen Tons wahrgenommen.

Abbildung 9. Verzerrung im Ohr: Frequenzanteile, die durch zwei Frequenzen entstehen: 1 kHz und 1,6 kHz. Nur die beiden Anteile unter 1 kHz sind hörbar.

Fazit

Normalerweise sollten Deine Mikrofone keine Verzerrungen aufweisen. In der Praxis kommt es aber doch manchmal vor. Messungen wie THD und Differenzfrequenzverzerrung zeigen nicht alles. Die Zahlen in den technischen Daten können aber als Hinweis darauf dienen, wie „gut“ das Design ist. Was wir mit dem Ohr wahrnehmen, ist ziemlich komplex, weil das Ohr selbst Verzerrungen erzeugt. Trotz der Zahlen gilt: Je mehr Verzerrungen ein Mikrofon hat, desto dumpfer und undeutlicher klingt die Aufnahme.

Referenzen

[1] IEC 60.268 Sound System Equipment, part 2: Explanation of general terms and calculation methods.

[2] IEC 60.268 Sound System Equipment, part 4: Microphones.

[3] Geddes, Earl R.; Lee, Lidia W: Auditory Perception of Nonlinear Distortion - Theory. AES 115th Convention Paper 5890. 2003.

[4] Geddes, Earl R.; Lee, Lidia W: Auditory Perception of Nonlinear Distortion. AES 115th Convention Paper 5891. 2003.

[5] Toole, Floyd E.: Sound Reproduction - The Acoustics of Loudspeakers and Rooms. Focal Press 2008. ISBN 978-0-240-520094